Les technologies d’imagerie numérique ont envahi notre quotidien. On en trouve partout et nous les utilisons sans même nous en rendre compte. Pour comprendre comment fonctionne un capteur d’image, comment ils sont conçus et fabriqués, suivez le guide…

Le capteur d’image est une technologie résolument ancrée dans les années 2000, avec la banalisation de la photo numérique. Avant cela, évidemment, il était déjà possible de s’acheter une caméra numérique en 1997. Le Sony Digital Mavica MVC-FD5 était vendu à l’époque 6 000 francs (900 euros environ) et on stockait les images… sur des disquettes 3,5 pouces !

Que de chemin parcouru en 20 ans, tant au niveau des performances que des prix ! Mais l’histoire de la photographie électronique remonte à plus longtemps que cela. L’effet photo-électrique, principe fondamental des capteurs d’images, fut publié pour la première fois en 1887 par un physicien allemand dont tout le monde connaît le nom aujourd’hui : Heinrich Rudolf Hertz. Mais il faut attendre 1905 pour qu’on le comprenne vraiment, avec les travaux d’un certain Albert Einstein, qui propose une première explication de ce phénomène, basée sur le modèle particulaire de la lumière. Des « particules » élémentaires de lumières, les photons, déposent une énergie donnée et quantifiée dans un matériau, suffisante pour libérer un électron (ou plusieurs). A l’époque c’était un modèle absolument révolutionnaire. Et c’est toujours ce même principe qui officie dans les pixels des capteurs d’images, en convertissant la lumière incidente en quantité électriquement mesurable.

Des débuts tardifs

Comme souvent en physique fondamentale, il faut un certain temps pour qu’un principe découvert et correctement théorisé trouve ses premières applications, et dans le cadre des capteurs d’images, il faut attendre 1968 avec les travaux de Noble pour voir débarquer les premiers concepts de capteurs d’images. On ne parle bien évidemment pas de pixels actifs (ou APS : active pixel sensors) mais d’une simple matrice de photodiodes, convertissant la lumière reçue en courant électrique. Un circuit d’adressage permet de venir lire une à une les valeurs de ces courants pour former, à terme une image. Il ne s’agit pas de CCD (Charge Coupled Device), mais bel et bien de capteur à transistor, même si le MOS, et à fortiori le CMOS n’existait pas à l’époque.

Malgré cette antériorité de concept, le CCD, inventé par Boyle et Smith des laboratoires AT&T / Bell Labs en 1969, fut le premier à connaître un véritable essor industriel. La raison est relativement simple : à l’époque, les finesses de gravures des circuits à transistor étaient si grossières que la taille requise pour réaliser un capteur à pixel passif, et à fortiori un APS donc, aurait été tout simplement prohibitive. Le CCD, de conception extrêmement simple, permettait déjà en 1975 la fabrication d’une vraie caméra numérique Fairchild d’une résolution de 100 x 100 pixels !

Capteur d’image : l’arrivée du CMOS

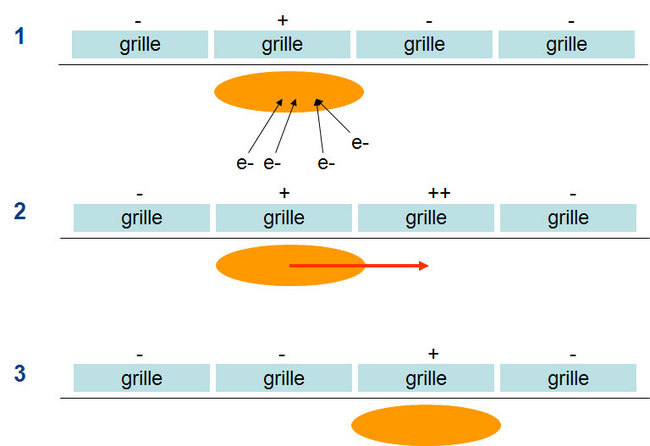

Faute d’une finesse de gravure suffisante pour les transistors, le CCD a longtemps fait cavalier seul sur le terrain de l’imagerie électronique. Il faut attendre 1993 pour voir apparaître le concept de capteur à pixel actif (ou APS) décrit par Nakamura (Olympus) et Fossum. Depuis, le CMOS a pris le pas sur le CCD dans les applications commerciales. Et pour cause : la simplicité de conception du CCD n’a d’égal que sa complexité de mise en œuvre ! Il faut en effet de multiples sources de tension, parfois très élevées (entre 10 et 20V), parfois négatives, pour faire fonctionner un CCD là où un capteur CMOS fonctionne tout simplement avec une alimentation standard (généralement 3.3V ou 1.8V). Il n’en fallait pas plus pour convaincre l’industrie des applications numériques mobiles (téléphone portable en tête), toujours prompte à économiser de la batterie.

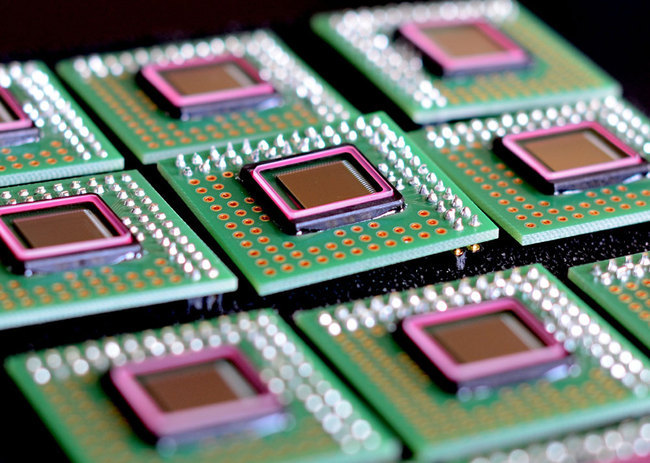

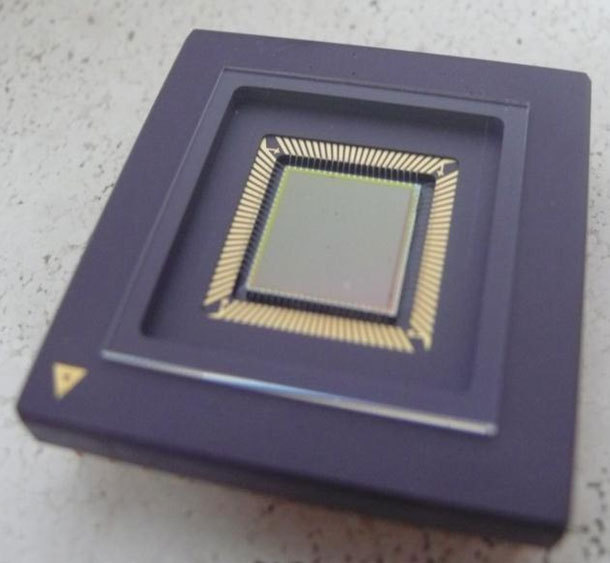

On le sait peu, mais l’industrie du capteur d’image est un savoir-faire fortement ancré en Europe et en France notamment. Quand Eric Fossum aux Etats-Unis et Nakamura au Japon travaillaient sur leurs capteurs d’images à pixels actifs, un groupe de travail de l’IMEC (Belgique) réalisait des travaux similaires dans son coin. Ce groupe a donné naissance à de multiples sociétés aujourd’hui, très actives dans la conception de capteurs d’image. Citons notamment FillFactory (rachetée par Cypress puis ON semi-conductor), qui a conçu le capteur d’image Full-Frame du DCS 14n à l’époque où Kodak existait encore :

On le sait peu, mais l’industrie du capteur d’image est un savoir-faire fortement ancré en Europe et en France notamment. Quand Eric Fossum aux Etats-Unis et Nakamura au Japon travaillaient sur leurs capteurs d’images à pixels actifs, un groupe de travail de l’IMEC (Belgique) réalisait des travaux similaires dans son coin. Ce groupe a donné naissance à de multiples sociétés aujourd’hui, très actives dans la conception de capteurs d’image. Citons notamment FillFactory (rachetée par Cypress puis ON semi-conductor), qui a conçu le capteur d’image Full-Frame du DCS 14n à l’époque où Kodak existait encore :

On peut citer également CMOSIS qui conçoit aujourd’hui le capteur d’image de dernier haut de gamme Leica :

Ou encore Caeleste, active dans le domaine de l’imagerie scientifique et Xenics, spécialiste de l’infrarouge.

La France n’est évidemment pas en reste, avec notamment ST Micro-electronics à Grenoble, l’une des usines de fabrication les plus performantes au monde en terme de capteurs d’image numériques. On trouve les produits de ST Micro dans certains smartphones. On pourra parler également de Trixell, grand spécialiste de l’imagerie numérique médicale, basée près de Grenoble également. Bref, dans les capteurs d’images, il n’y a pas que l’Asie et les Etats-Unis, loin s’en faut, et c’est tant mieux.

Capteur d’image : dessine-moi un capteur d’image

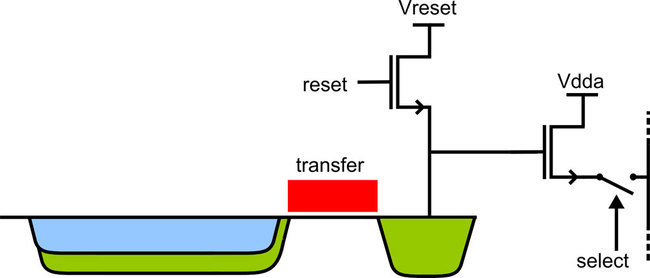

Concrètement, comment nait un capteur d’image ? Il convient d’abord de tordre le cou à une idée reçue qui a trop longtemps vécu : les capteurs d’images sont avant tout des composants analogiques. Certes, on les retrouve dans les appareils photos numériques et bien évidemment, certains intègrent une lourde section de traitement d’image sur la puce même, mais, fondamentalement, les pixels sont des éléments essentiellement analogiques. Et en cela, ils sont encore aujourd’hui dessinés, sur un logiciel de CAO certes, mais à la force de la souris par des concepteurs avec un solide background en physique des semi-conducteurs. Voici par exemple un design simplifié d’une matrice de 3 x 3 pixels au pas de 2.5um en technologie CMOS 0.18um.

L’avantage du CMOS est de pouvoir intégrer au capteur d’image une foultitude de fonctions particulièrement utiles, en numérique comme en analogique. Parmi les intégrations les plus courantes, citons les régulateurs de tension, les corrections de pixels morts, le contrôle d’exposition automatique (surtout pour les smartphones), la balance des blancs automatique (là aussi pour les smartphones) et bien évidemment, l’obturateur sur puce.

Face avant ou face arrière ?

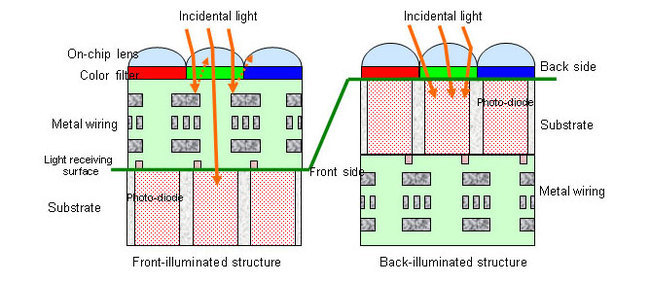

L’image ci-dessus montre aussi l’une des limites inhérentes aux capteurs d’images CMOS. En effet, toute la surface du pixel n’est pas sensible. Une partie de la lumière est reflétée vers l’extérieur, notamment à cause des parties métalliques. Ainsi, la surface vraiment utile du pixel est des plus limitées. Sur l’image ci-dessous, on montre la surface réellement active, optiquement parlant, toujours pour un pixel à quatre transistors au pas de 2.5um.

On voit bien ici que, pour les pas de pixels petits, la perte de sensibilité liée tout simplement aux réflexions sur le métal est assez importante. Pour compenser, il existe plusieurs solutions. La première consiste à installer au-dessus du pixel des microlentilles. Mais la solution la plus tendance en ce moment consiste à utiliser un éclairage en face arrière, ou BSI pour Back Side Illumination. On peut d’ailleurs combiner cette technologie avec les microlentilles. Voici une comparaison entre les deux méthodes.

Il est bien évident que le gain de sensibilité lié à cette technologie est assez variable selon les capteurs. Tout dépend en effet de la taille du capteur d’image. Quand les pixels sont petits, comme c’est le cas sur les capteurs d’images des smartphones, ou même ceux des appareils compacts, le bénéfice est immédiat. Sony par exemple revendique près de 5dB supplémentaire en sensibilité absolue pour un détecteur dont le pas de pixel est de 1.75um. Pour les capteurs de réflex, au format APS-C, et à plus forte raison sur les full-frames, l’investissement ne semble pas encore justifié.

Pour la petite histoire, l’éclairage face arrière n’est pas une innovation réservée au CMOS. D’ailleurs, elle fut d’abord employée sur les CCD. Une autre société européenne, e2v, dispose de cette technologie depuis plus d’une quinzaine d’année.

Capteur d’image : conçu pour la production en masse

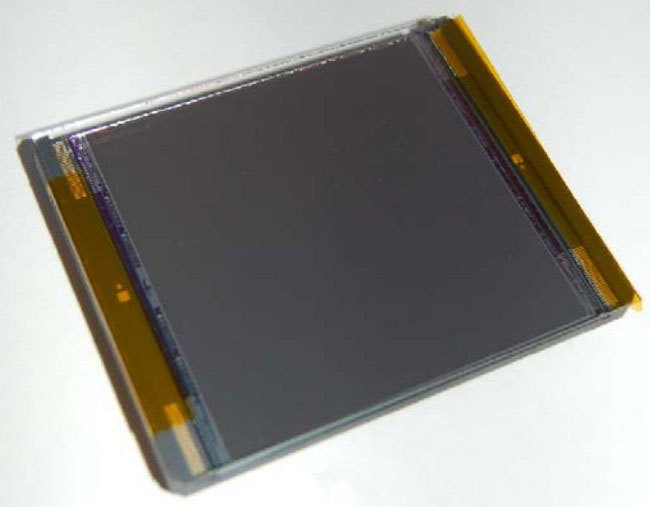

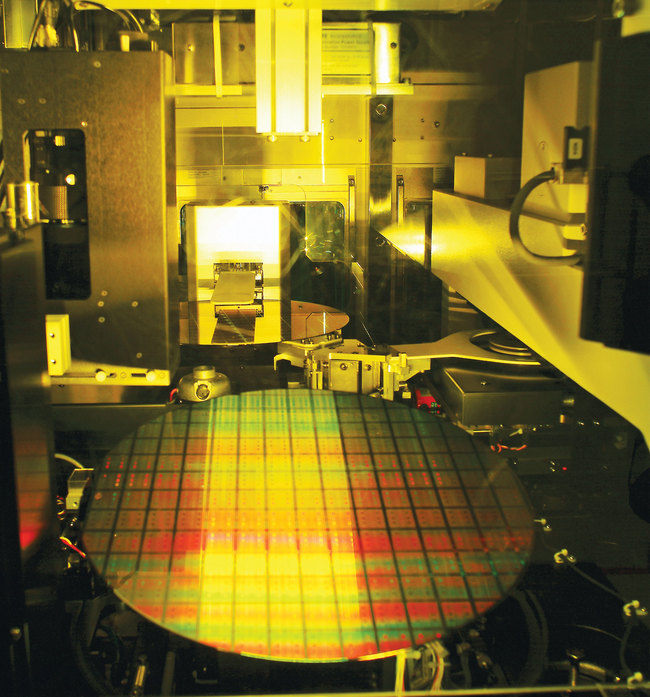

Une fois les capteurs dessinés, les plans, ou « masques » sont envoyés à la fonderie de silicium, qui reproduit par lithographie les différentes couches (implants, poly, contacts, métaux, isolants…) du détecteur. Comme les autres composants électroniques, les capteurs d’images sont livrés sur des Wafer (galettes en français dans le texte) de silicium.

Selon les volumes et les technologies, un Wafer coûte en sortie de fabrication entre 1 500 et 6 000 euros selon le diamètre. Ceci explique que la taille du capteur d’image lui-même influe directement sur le prix des appareils photos. Quand un capteur d’image est gros (pour un full-Frame par exemple), le nombre de composants fabriqués sur un même wafer diminue et mathématiquement, leur prix augmente. A cela s’ajoute aussi des défaillances, constantes par unité de surface sur un Wafer. Mathématiquement, lorsqu’un défaut dans le cristal « tue » un capteur, l’impact économique sur la production totale est moindre si le capteur est petit. C’est le cas par exemple sur les capteurs de smartphones qui coûtent en sortie de chaine de fabrication entre un et deux euros.Au-delà de l’aspect technologique, les capteurs d’images posent une question plus fondamentale, liée à notre perception du réel. En effet, au risque de faire de la métaphysique de comptoir, la principale fonction d’un capteur d’image n’est pas de représenter une scène telle qu’elle est, mais bien telle que nous la percevons, et ça change radicalement la donne.

Les capteurs d’image sont essentiellement des capteurs noir et blanc. Ils répondent avec une efficacité plus ou moins grande selon la couleur de la lumière qu’ils captent, comme on peut le voir sur le diagramme suivant :

Réponse d’un capteur d’image (en Ampère par Watt) en fonction de la longueur d’onde. Le bleu est à 400nm, le rouge à 800nm pour une collection de capteurs d’image. Les capteurs d’images courants sont plus à l’aise dans le vert. Source : www.caeleste.be.

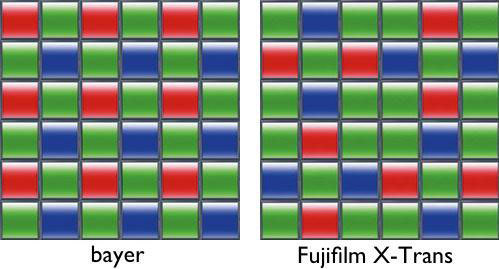

Une fois les photons de différentes longueurs d’onde convertis en électron. Il devient impossible de distinguer les couleurs. Pour ce faire, on a recours à des filtres colorés, similaire à ceux que l’on trouve sur les écrans LCD, par exemple. Chaque pixel reçoit un filtre coloré (rouge, vert, bleu) selon un pavage régulier.

Le plus connu reste le filtre Bayer, traditionnellement utilisé sur les capteurs d’images CMOS et CCD. Son utilisation pose en revanche des problèmes d’aberrations chromatiques comme on peut le voir ci-dessous.

Pour corriger le tir, les appareils photos intègrent un filtre optique passe bas, qui réduit in fine le pouvoir de définition de l’appareil mais qui évite dans une certaine mesure ces problèmes de rendu désastreux des couleurs sur les transitions trop franches (noir profond sur blanc saturé). Fuji a récemment remis en question le filtre de Bayer avec sa technologie Xtrans, cassant la symétrie inhérente au Bayer, et permettant du même coup de se passer de filtre passe-bas, une solution qui semble des plus efficaces.

Pourquoi deux fois plus de pixels verts ?

On a vu plus haut que les capteurs d’images étaient moins sensibles dans le bleu et dans le rouge. La logique voudrait que l’on renforce la présence de pixels rouges et bleu pour compenser. Et bien non ! Les filtres de couleurs prédominants sont les verts. Ici, il s’agit d’une adaptation non pas à la réalité… mais à la perception de l’œil humain, particulièrement sensible aux détails dans ces nuances.

Filtre infrarouge : faites le test !

La plupart des appareils photos numériques disposent d’un capteur filtrant l’infrarouge. Pourquoi ? Tout simplement parce que les filtres de couleurs redeviennent tous transparents dans l’infrarouge. Or, on a vu plus haut que les capteurs d’image restent sensibles dans le proche infrarouge (aux environ de 900nm de longueur d’onde). Donc si la scène photographiée contient de l’infrarouge, cette lumière va être perçue par tous les pixels au risque de délaver les clichés, voire d’en amoindrir la netteté. Apple (mais aussi Sony) ont frappé un grand coup en intégrant un filtre infrarouge dans leur capteurs d’images pour smartphones. C’est le cas chez Apple depuis le 4S, dont les capacités photographiques ont été largement discutées par ailleurs. Pour savoir si le vôtre a un filtre infrarouge, faites le test suivant : photographiez votre télécommande quand vous appuyez sur un bouton, tout simplement. Si tel est le cas, la lumière de la diode de votre télécommande devrait être sérieusement amoindrie par rapport à notre photo :

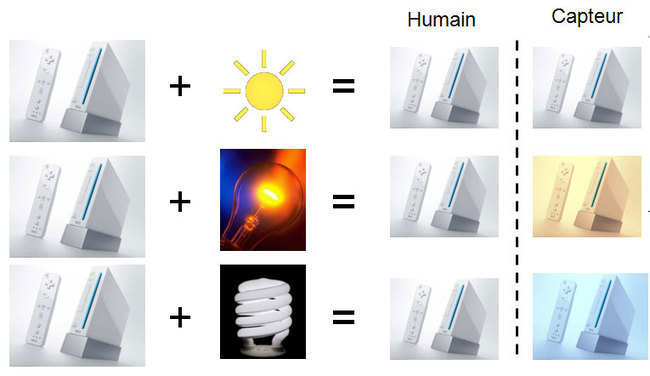

Pourquoi il y a une balance des blancs ?

Notre capteur d’image est désormais sensible aux couleurs. C’est bien. Seulement voilà, la couleur d’un objet dépend de l’éclairage. C’est une réalité physique… que notre œil et notre cerveau n’aiment pas du tout. Ainsi, un être humain fait sa propre balance des blancs. Il corrige, sans s’en rendre compte la couleur des objets en fonction des teintes de références qu’il connaît. Il réalise en quelque sorte une balance des couleurs automatiques selon l’éclairage. C’est pour cette raison que la balance des blancs a été inventée. Là encore, il s’agit d’une adaptation de la technologie aux capacités de l’œil humain et non pas à la réalité.

De l’absence de mesure absolue

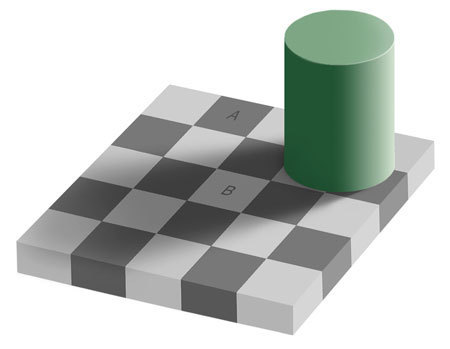

Dernier point que nous aborderons ici : le contraste. Contrairement aux capteurs d’images CMOS ou CCD, l’œil humain n’est pas capable de réaliser une mesure absolue de luminosité. Il est particulièrement sensible aux différences de luminosité, ce qui donne d’ailleurs lieux à une multitude d’effets d’optiques délirants. Ne retenons que l’échiquier d’Adelson ci-dessous :

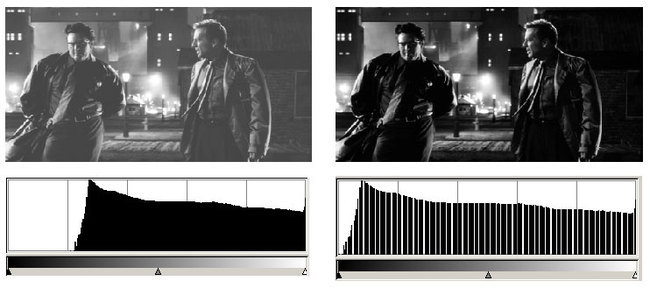

Ainsi, les capteurs d’images disposent de fonction de clamp, adaptant automatiquement le niveau de noir des capteurs d’images pour couvrir un maximum de dynamique. Ainsi, dans l’image ci-dessous, l’image de droite n’est qu’un étirement de l’histogramme de celle de droite. Pour une machine, elle contient exactement la même quantité d’information. Mais pour un être humain, celle de gauche apparaît comme délavée.

Capteur d’image : un domaine en constante évolution

Parce que la vision humaine est sans aucun doute le sens le plus sollicité, la technologie des capteurs d’image est en perpétuel bouleversement. Et ces progrès technologiques ne bénéficient pas qu’aux appareils photos et autres smartphones. Les cameras envahissent tous les domaines, que ce soit pour le diagnostic médical non intrusif, l’exploration spatiale, l’industrie, etc. Bon nombre de technologies originellement destinées à recherche spatiale, comme l’éclairage en face arrière, il y a 10 ans, se retrouvent désormais dans nos smartphones. De même les détecteurs ultrasensibles développés par le CERN entre autre, permettant de capter une unique particule ouvrent la voie à une nouvelle génération de capteurs d’images rayon X à très faible doses… et en vraie couleurs ! A une heure où les technologies télévisuelles stagnent, en attendant que l’OLED décolle enfin, il est vraiment agréable de voir que certains domaines peuvent encore nous surprendre.

Note : Cet article plutôt technique est tiré de mon cours sur la technologie des capteurs d’images à l’université Paris XIII. J’ai essayé de clarifier et de simplifier au maximum le propos, mais si vous avez des questions, n’hésitez pas à poster ci-dessous ! ;-)